【2016/09/25】

本地shegong建立计划已完成三分之二了。

kaifang的8.5G进去了,建立了大索引,加起来11个G。

现在导入souyun和杂七杂八的二十多个小库加起来23G加10G。

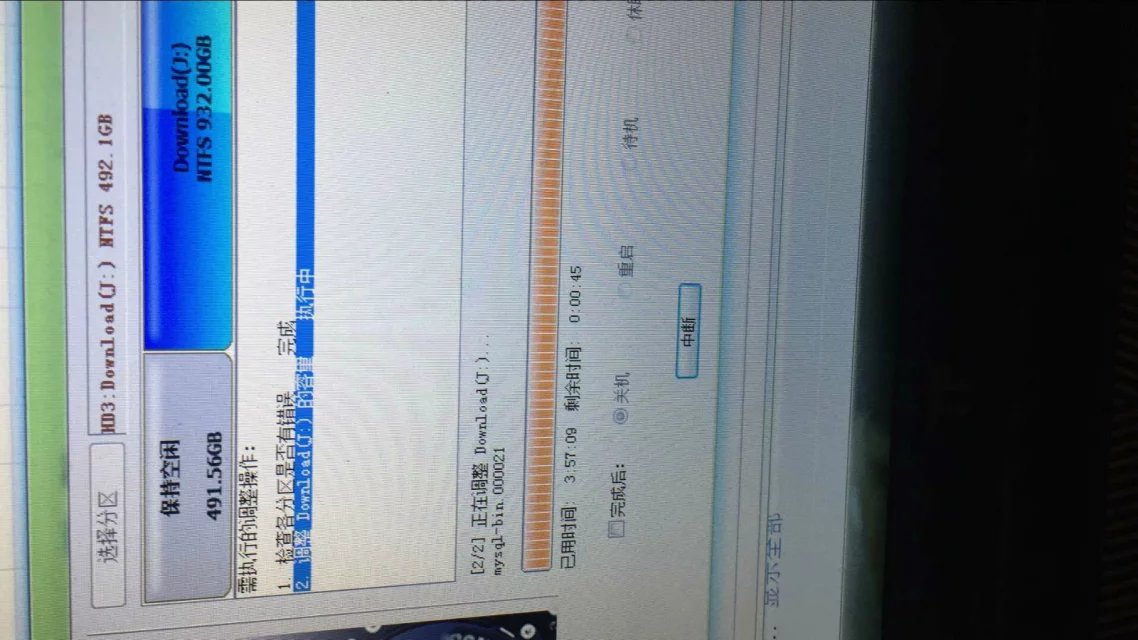

souyun是mysql,跑了四个小时全文索引,索引文件30G还在增加,于是放弃。 于是改普通索引,跑了数个小时2.8G还在增加,没有完的意思,再次放弃。 于是改思路,先索引再表,结果遇到10XX错误,修复后依旧慢,放弃。

最后用了黑chAN法,绕过sql后在本地文件端进行底层操作,虚拟机mac后因为文件太大损伤硬盘严重,放弃。

于是,我就只能导出mysql,试了试xls,每秒200条,放弃。 试了试sql后缀导出,慢,放弃。

最后用csv2个小时多,搞定,导出23G。

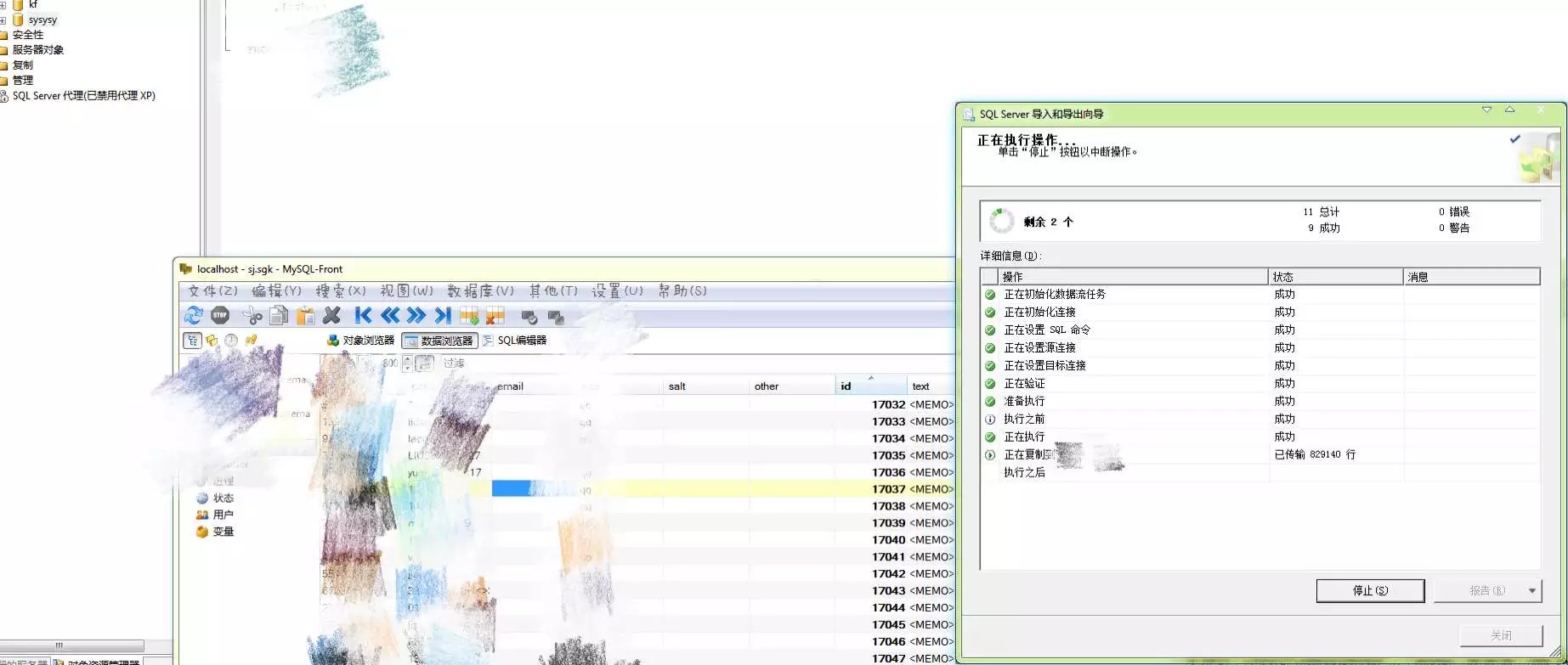

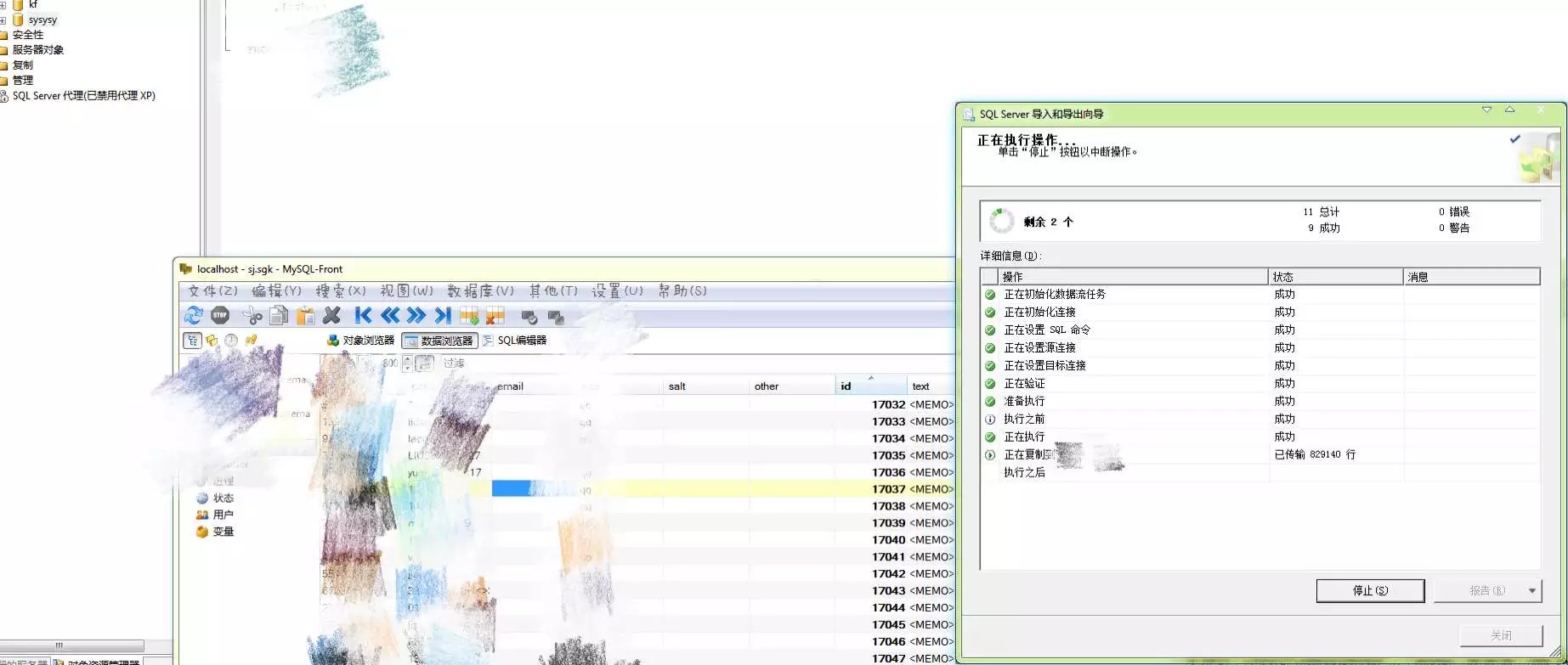

然后正在导入server中…刚开始跑了几十万,然而三个小时过去了,现在几千万了还在跑,我估计这个ku得有个好几个亿。

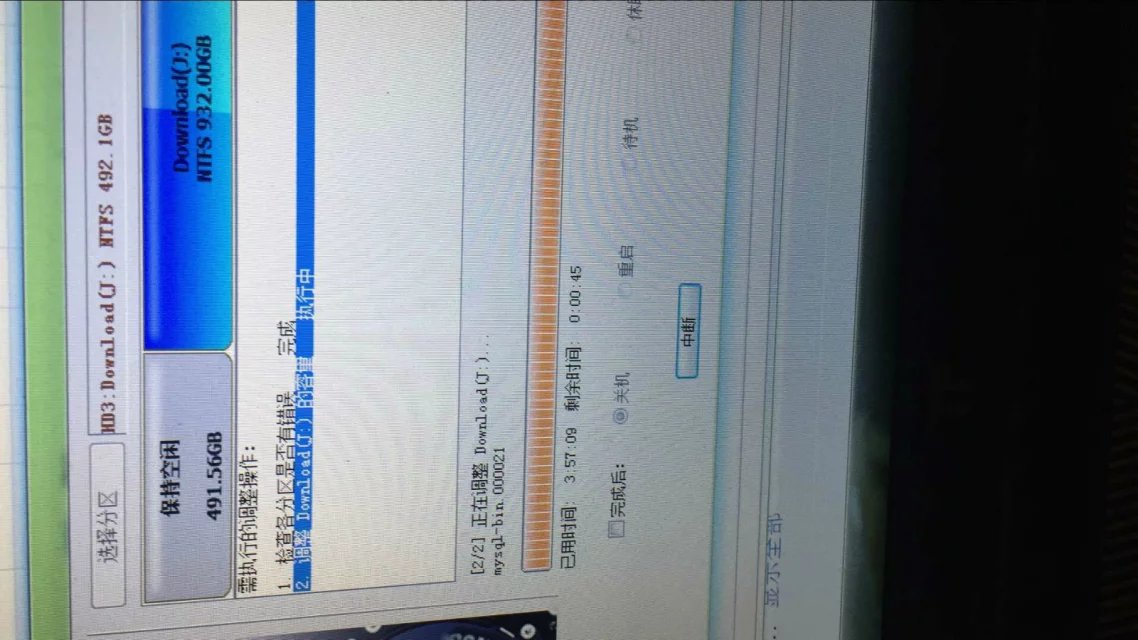

这个要是完事了都是小事,最后的93G的tengxu…n才是大头,我都不知道本地如何完成这十四点一亿的数据索引,我知道分库,但是伤硬盘啊。

我打算要不就再买一块硬盘,硬盘盒处理,不买移动容易坏。

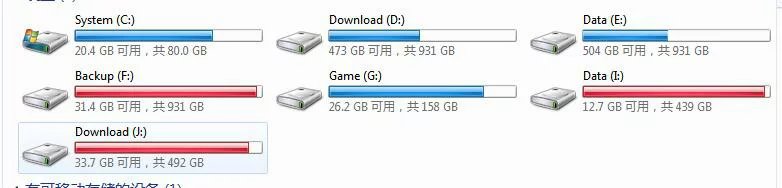

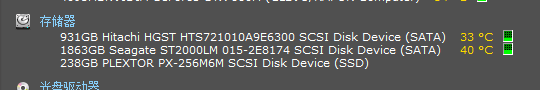

唉,是时候买新硬盘了,256+2T太小了。 有一些下载不到的是开云的朋友给的,真心跪一波。我好菜啊…

【2016/09/27】

终于把这傻逼数据库导入进去了。

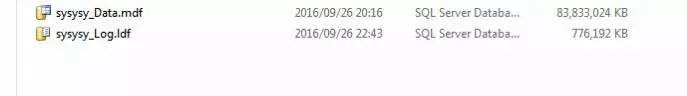

真费劲,导入后结果显示100G多,一看有一堆未使用,没办法,收缩一下成80G多。

然后二话没说,直接开启自动收缩。 后来做两个关键列的索引,就是直接非聚集普通索引,报错。

我以为是数据太大了导致的。没办法。

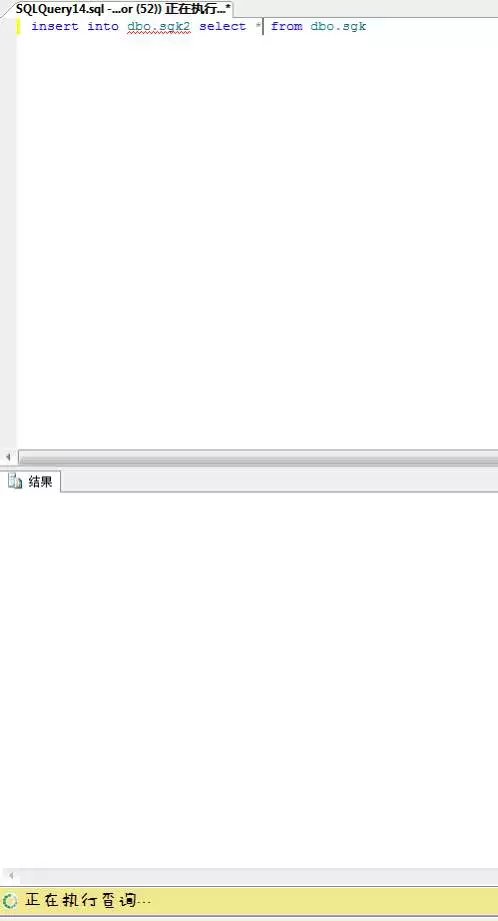

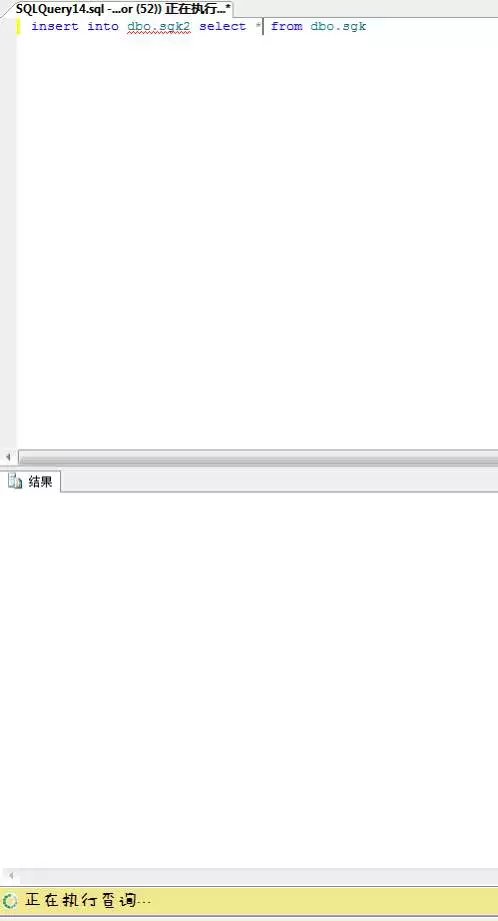

跟群里菊苣聊,使用了先索引后插入复制法,一个破语句研究了半个小时,最后被我弄明白了。

语序有问题。改了半天,结果还得用可恶的限制行数做测试,测试倒是没问题,可是更大的问题来了…

之后,那就试试呗,日志文件暴涨,我删除了几年前的老视频节约空间,还不行,日志根本没法限制。

没办法,我分离数据库,然后删除日志,再挂进去先… 实在没办法了,干脆直接再次优化后直接做索引,非聚集。

我这算是破罐子破摔了…谁成想……… 挂机了一晚上,搞定了,神她妈搞定了草。索引建立起来了。

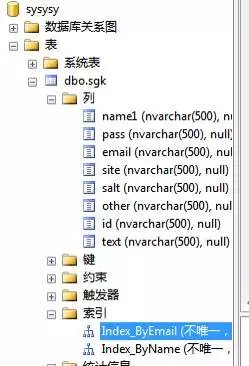

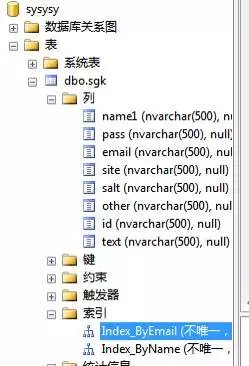

某L菊苣也说了,你50G的数据主体,没索引前80G,就是因为你全都是nvar500导致的。

以至于现在做完索引的总数据库已经120G了。。。

妈的←_← 我现在想办法再把除了两个索引之外的列都变成text就完事了。

但是因为数据太大,就他妈超时,我一会强制修改配置文件,超时设置1天,我看你还报错不。。。

你问我为什么不都text,妈的傻逼mssql不支持text索引啊操蛋。。。。。

你问我为啥只索引两列,我索引pw有鸡毛用额………

至此为止,shegong本地计划已完成三分之二。

操你妈tengxun的是90G本体,15亿数据啊,我这个才4亿就这样了,15我怎么玩啊。。。。。。。。。。。。。。。。。

现在我有的这些综合整理的,已经够任何一个常上网的人,他的东西了,这很机霸⊙▽⊙

继续阅读研究点新东西,玩一玩SQL,搞个shegong试试看~【更新到2016/09/28】